Сверхразум выходит из-под контроля. Ученые обеспокоены новой угрозой

МОСКВА, 3 окт — РИА Новости, Владислав Стрекопытов. Достижения последних лет в области машинного обучения позволили создать автономные роботизированные системы в том числе военного назначения. В связи с этим в научной среде с новой силой разгорелась дискуссия о потенциальных рисках, связанных с развитием искусственного интеллекта. Недавние исследования показали, что решения, принятые компьютером, часто расцениваются людьми как несправедливые, а контроль над сверхразумом в долгосрочной перспективе невозможен из-за фундаментальных принципов, заложенных в его основе.

От фантастики к реальности

Автором термина "искусственный интеллект" (ИИ) считают Алана Тьюринга, британского математика, одного из основоположников теории информатики. Он заговорил об этом еще в 1950-м.

Более полувека тема восстания машин была чрезвычайно популярной, но в целом не выходила за рамки фантастических романов и кинофильмов. Всерьез экзистенциальные риски, связанные с ИИ, начали обсуждать сравнительно недавно — после того, как цифровые технологии глубоко проникли во все сферы жизни.

Без компьютера и смартфона современный человек не в состоянии обойтись и нескольких часов. Даже кратковременный сбой связи или отключение интернета способны парализовать целые отрасли, вызвать транспортный и энергетический коллапс.

Но "проблема остановки", как называют эту ситуацию специалисты, — не самая худшая перспектива. Пока машины можно выключить или перепрограммировать, они остаются под контролем человека. Реальные угрозы возникнут, когда ИИ станет умнее нас. И человечество вплотную подошло к этой черте.

Умнее самых умных

Cегодня ИИ анализирует медицинские снимки точнее любого врача, оптимизирует логистические пути лучше самого опытного диспетчера и выполняет еще тысячи производственных и управленческих операций эффективнее человека. А мощности суперкомпьютеров по обработке и анализу информации многократно превышают возможности всех людей на планете, вместе взятых.

По словам шведского философа, профессора Оксфордского университета Ника Бустрема, известного своими работами в области трансгуманизма, наступает эра сверхразума — искусственного интеллекта, который не только "умнее лучших человеческих мозгов практически во всех областях", но и готов взять на себя творческие функции, традиционно считающиеся прерогативой человека. Но главное в сверхинтеллектуальных системах — способность действовать самостоятельно, принимать собственные решения на основе анализа внешней информации.

Компьютерному сверхразуму собираются доверить управление отдельными процессами на производстве и в логистике. Чисто технически реализовать это несложно, но непонятно, в какой степени человек сможет корректировать действия машины и насколько велик риск того, что ИИ в определенный момент выйдет из-под контроля. Кроме того, неясно, как заложить в компьютер понятия об этике и справедливости, которые влияют на принятие решений человеком.

Справедливость против рациональности

Хотя этические вопросы, связанные с использованием сверхразума, остаются открытыми, такие системы уже активно применяют в том числе в социальной сфере. Немецкие ученые выяснили, как на это реагируют люди.

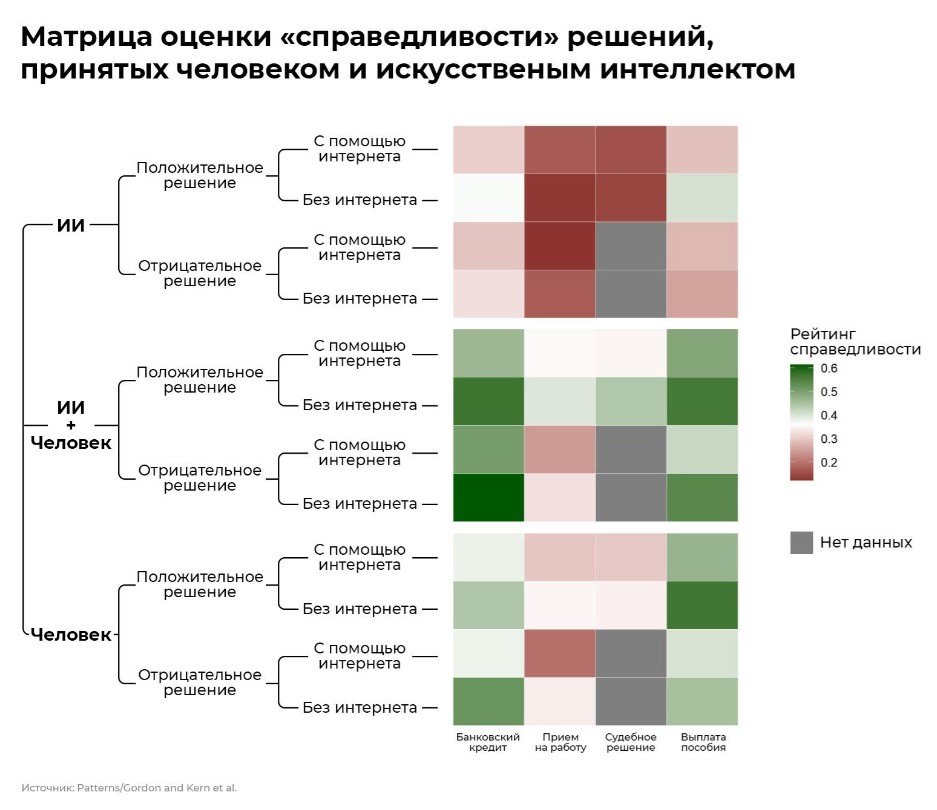

Участникам эксперимента предложили оценить по условной шкале справедливости решения, которые принимались в автоматическом, полуавтоматическом или полностью ручном режиме в четырех конкретных ситуациях: при запросе на выдачу банковского кредита, выборе кандидата на замещение вакансии, судебном разбирательстве и назначении пособия по безработице. Худшими оказались автоматические решения, а наиболее справедливыми — те, которые принимали совместно компьютер и человек.

© Инфографика

Авторы работы отмечают, что искусственный интеллект обладает несомненным преимуществом при обработке больших объемов данных, но не учитывает сопутствующие обстоятельства — так называемый контекст принятия решения. А в ситуациях, затрагивающих интересы людей или касающихся их здоровья и жизни, это может стать критическим фактором.

"Сверхразумные" автоматы Калашникова

В 2015-м сотни ведущих мировых экспертов в области робототехники и искусственного интеллекта опубликовали открытое письмо к ООН с призывом внести в Конвенцию о применении обычных видов оружия запрет на смертоносные автономные системы, способные самостоятельно, без участия человека определять цели и уничтожать их.

"Петицию о запрете роботов-убийц" подписали около 1300 ученых и специалистов, включая предпринимателя Илона Маска, знаменитого физика Стивена Хокинга, сооснователя Apple Стива Возняка, соучредителя Skype Яана Таллинна и философа-активиста Ноама Хомского. Документ опубликовали в день открытия Международной объединенной конференции по искусственному интеллекту — главного мирового форума в этой области.

"Технологии искусственного интеллекта достигли точки, когда развертывание автономных систем практически осуществимо в течение нескольких лет, а не десятилетий, — отмечается в письме. — И ставки очень высоки: они могут произвести третью революцию в военном деле — после пороха и ядерного оружия. <…> Автономным оружием завтра могут стать автоматы Калашникова".

В отличие от ядерных боеприпасов роботизированные системы не требуют дорогостоящего или труднодоступного сырья. В теории их сможет создавать практически любая страна. Поэтому, считают ученые, если эти виды вооружений вовремя не запретить, они очень быстро распространятся, попадут в руки террористов и приведут к дестабилизации в мире.

Тем не менее машины для убийства на основе искусственного интеллекта продолжают разрабатывать. Технологические прототипы уже есть. К примеру, автономный или полуавтономный режим заложен в южнокорейскую сторожевую пушку Samsung SGR-A1, британский боевой беспилотник BAE Systems Taranis, американский беспилотный противолодочный корабль Sea Hunter.

CC0 / Mike Young /

Модель боевого беспилотника BAE Systems Taranis на выставке Farnborough Airshow 2008

Контроль над сверхинтеллектом

Впервые этические правила для роботов сформулировал в 1942 году американский писатель-фантаст Айзек Азимов. Он назвал их тремя законами робототехники. Первый — робот не может причинить вред человеку или своим бездействием допустить, чтобы вред был причинен. Второй — робот должен повиноваться всем приказам человека, кроме тех случаев, когда они противоречат первому закону. И третий: робот должен заботиться о своей безопасности в той мере, в которой это не противоречит первому или второму законам.

Сразу было ясно, что эти законы так и останутся в области фантастики. И яркое тому подтверждение — автономные системы вооружения. Ведь их основная цель — причинение вреда человеку. Кроме того, Азимов имел в виду "обычный", жестко программируемый искусственный интеллект — такой, как у антропоморфных роботов или автомобилей без водителя. А сверхразум способен к обучению. Любая сверхинтеллектуальная система запускает программу аналитической обработки информации, подразумевающей формирование у машины "нового опыта" и применение его в будущих действиях.

Исследование специалистов по математике и вычислительной технике из пяти стран продемонстрировало, что даже теоретически невозможны системы автоматического контроля и корректировки решений, принятых компьютерным сверхразумом. Заложенный в него алгоритм машинного обучения основан на принципах нейронных сетей, аналогичных тем, что в мозге человека, а способности находить закономерности в больших объемах данных превосходят человеческие.

Ученые предупреждают, что рано или поздно сверхинтеллект, анализируя шаблоны действий человека, научится их копировать, а потом и обходить. Так же, как мы, наблюдая за повадками шимпанзе, в конце концов сможем его перехитрить. Искусственный разум уже обыгрывает людей в шахматы, шашки и другие интеллектуальные игры, создает художественные произведения на основе анализа прочитанных книг и просмотренных картин. И это только начало.